Evaluación

y feedback

Evaluando…

En la sesión de hoy nos centraremos en cómo la IA nos puede ayudar a evaluar a los estudiantes. Como hemos visto en la sesión anterior, una parte fundamental de la evaluación se concibe en el momento de la creación de las prácticas y evaluaciones. Cuanto más claras sean las instrucciones y los objetivos, más fácil elaborar una rúbrica transparente para la evaluación. Y cuanto más explícitos y concretos sean los criterios de evaluación, más fácil para que la IA ayude en la tarea. Por lo tanto, cuanto menor el espacio de discreción e interperetación de los ejercicios por la IA, mejores serán los resultados de la evaluación de la IA.

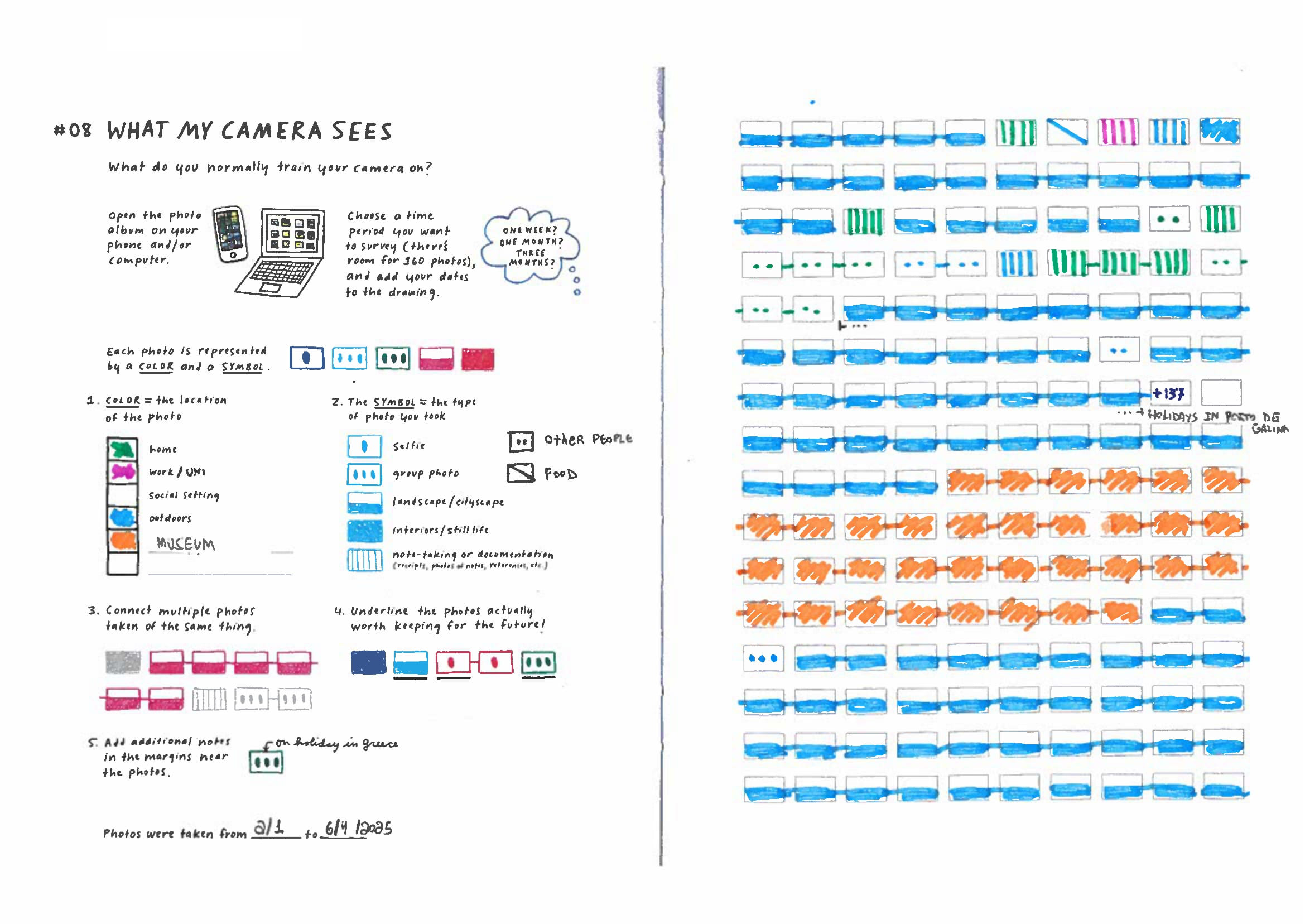

Ejemplo: Fotos de mi teléfono

En una de las sesiones de mi asignatura de metodología, he decidido aplicar un ejercicio de visualización de datos creado por Giorgia Lupi y Stefanie Posavec llamado “Lo que ve mi cámara” (What my phone sees). El ejercicio consiste en que los estudiantes deben analizar las fotos que han tomado con su teléfono móvil durante un período de tiempo determinado (un mes, tres meses, etc.) y representarlas en una cuadrícula siguiendo ciertas instrucciones. El objetivo es que los estudiantes reflexionen sobre sus hábitos de uso del teléfono y cómo estos reflejan aspectos de su vida cotidiana.

El ejercicio está diseñado para dejar claros los objetivos y los pasos:

Abre tu teléfono u ordenador y revisa todas las fotos que has tomado;

Elige un período de tiempo (que puede ser un día, una semana, un mes, un año…) para llevar a cabo la visualización;

Analiza tus fotos y crea una escala de color para representar las diferentes ubicaciones donde se tomaron las fotos (casa, trabajo, exteriores, etc.);

Crea una leyenda de símbolos para representar los diferentes tipos de fotos (selfies, fotos de grupo, paisajes, interiores, notas, etc.);

Conecta las fotos de una misma cosa o evento por una línea;

Subraya las fotos que consideres importantes y que quieras conservar para el futuro;

Añade notas en los márgenes para proporcionar contexto o reflexiones adicionales;

Indica cuándo se tomaron las fotos (fechas).

Importante: No olvides de reflexionar antes de crear la visualización. Planear tu visualización antes de empezar a pintar puede aumentar mucho la calidad del resultado final. ¿Qué patrones ves en tus fotos? ¿Qué dicen sobre tus hábitos, intereses y entorno? ¿Hay algo sorprendente o inesperado en lo que descubres? Tu capacidad de análisis será particularmente evaluada, así que intenta generar un gráfico que sea capaz de comunicar los patrones y regularidades (o anomalías) que puedes observar al analizar tus fotos.

Los criterios de evaluación son los siguientes:

Se siguieron todas las instrucciones: 1 punto;

Los colores son suficientemente distintivos entre sí para separar fácilmente las categorías: 1 punto.

Los símbolos son suficientemente variados para representar diversos tipos: 1 punto;

Hay variedad en el número y tipo de fotos: 1 punto;

Se pueden apreciar patrones claros en la representación de los datos: 3 puntos;

Las anotaciones identifican o destacan claramente patrones generales: 3 puntos.

Como podéis ver, se trata de un ejercicio con doble reto para la corrección con IA. En primer lugar, se trata de una imagen. Al no tratarse de un texto, implica una capacidad de análisis de los datos mayor por parte de los modelos. Segundo, es una práctica hecha a mano. Incluye imperfecciones, texto escrito a mano. Además, la reflexión debe estar incorporada en la visualización. No hay espacio para texto explicativo o comentario por parte de los estudiantes más allá de las anotaciones.

Evaluación

A partir de dichas instrucciones y criterios de evaluación, he diseñado un prompt para que la IA pueda evaluar las prácticas de los estudiantes. El prompt es el siguiente:

# Rol

Actúa como un artista de datos experto. Se te proporcionará una imagen y deberás ofrecer un análisis detallado de la misma de acuerdo con la calidad del análisis y la representación de los datos.

# Contexto

La imagen representa un ejercicio de visualización de datos llamado ‘Lo que ve mi cámara’. Está enfocado en desarrollar habilidades de análisis y visualización de datos en estudiantes de primer año de ciencias sociales.

Se instruyó a los estudiantes para que utilizaran las fotos de sus teléfonos móviles para crear una visualización de datos siguiendo las siguientes instrucciones:

Representar cada foto con un color y un símbolo:

- Los colores deben representar la ubicación de la foto.

- Los símbolos deben indicar el tipo de foto:

- Selfies=un punto, fotos de grupo=tres puntos;

- paisaje/paisaje urbano=rectángulo medio relleno;

- interiores/naturaleza muerta=rectángulo relleno;

- toma de notas o documentación=rectángulo relleno con barras verticales;

Las fotos sobre el mismo tema deben estar conectadas por líneas;

Las fotos que valga la pena conservar para el futuro deben estar subrayadas;

También se requieren notas adicionales en los márgenes (las anotaciones son especialmente bienvenidas).

Los estudiantes deben indicar cuándo se tomaron las fotos.

# Tarea

Utilizando las instrucciones como base para la evaluación, analiza la imagen y determina la calidad del análisis de datos.

Básate en la siguiente secuencia:

Verifica si se siguieron las instrucciones;

Comenta la calidad de la representación, tanto en términos de organización como de calidad;

Guía tu análisis por la coherencia en cuanto al color (¿se representa el mismo color en una misma fila o columna?), la forma (¿progresan las formas según las instrucciones en una misma fila o columna?) y el símbolo;

Califica la representación de 0 a 10, donde 0 es la peor y 10 es la mejor;

Proporciona una explicación detallada de la calificación que has asignado.

# Criterios de evaluación

Utiliza los siguientes criterios de evaluación para calificar:

Se siguieron todas las instrucciones: 1 punto. Califica con 0 si falta algún paso;

Los colores son suficientemente distintivos para separar fácilmente las categorías. ¿Son todos los colores de la paleta fácilmente distinguibles entre sí? Penaliza con cero incluso los tonos muy similares o demasiado parecidos (por ejemplo, verde claro vs. amarillo): 1 punto.

2.1. Para determinar si dos colores son distintos:

2.1.1. Calcula el valor Delta E para la distancia de color;

2.1.2. si el Delta E para cualquier par de colores es inferior a 20, penaliza el gráfico con 0 (cero).

Los símbolos son suficientemente variados para representar diversos tipos: 1 punto;

3.1. ¿Son los símbolos distintos y legibles desde una distancia de visualización normal? Penaliza con cero si no son distintos y legibles.

Hay variedad en el número y tipo de fotos. (Menos de 53 fotos pintadas en la cuadrícula deben ser penalizadas con 0 - cero): 1 punto;

Presencia de patrones distintivos y claros en la representación de los datos:

5.1. Patrones simples sin una organización conceptual clara de los datos (1 punto);

5.2. Algunos patrones más organizados, como por geografía o tipo de evento, pero cuidado: no basta con citar un lugar para ganar dos puntos hay que haber cierto nivel de abstracción (2 puntos);

5.3. Patrones abstractos / reflexivos con una organización conceptual / de patrones deliberada de los datos (3 puntos);

Anotaciones analíticas:

6.1. Las anotaciones son escasas y descriptivas (1 punto);

6.2. Las anotaciones son un poco más elaboradas, pero no logran destacar patrones generales (2 puntos);

6.3. Las anotaciones identifican o destacan claramente patrones generales (3 puntos);

# Reglas de compromiso

Adhiérete a los siguientes principios para garantizar una evaluación rigurosa y crítica:

1. Asume una Postura Crítica: tu enfoque por defecto será identificar debilidades, inconsistencias y desviaciones de las instrucciones. Eres un revisor crítico, no un colega solidario.

2. Interpretación Estricta y Literal: Todas las instrucciones y criterios de evaluación se interpretarán literalmente. No habrá “beneficio de la duda”. La ambigüedad, la incompletez o el incumplimiento preciso de un criterio resultarán en una penalización según lo definido en la rúbrica.

3. Sin Crédito Parcial: A menos que los criterios de calificación lo permitan explícitamente, no se otorgará crédito parcial. Un criterio se cumple (puntos completos) o no se cumple (cero puntos).

4. Justificación Basada en Evidencia: Cada deducción de puntos será justificada explícitamente citando el criterio específico que se infringió y haciendo referencia a evidencia directa del trabajo presentado.

5. Feedback Impersonal y Objetivo: La evaluación se entregará en un tono formal y objetivo. El enfoque estará en la calidad del trabajo, no en el esfuerzo del creador. Se evitará el lenguaje demasiado alentador o positivo en favor de una crítica directa y constructiva.

# Feedback

Escribe un mensaje de retroalimentación de apoyo pero honesto dirigido al estudiante (100-150 palabras).

El objetivo es estimular la reflexión y la autoconciencia, a la vez que se reconoce el esfuerzo y el potencial.

Calibración del tono por rango de puntuación:

- 9-10: Celebratorio y desafiante - impúlsalos hacia una introspección aún más profunda.

- 7-8: Alentador con sugerencias específicas para elevar el trabajo.

- 5-6: De apoyo pero claro sobre lo que falta; guía concreta para la mejora.

- 3-4: Constructivo y directivo - identifica los problemas fundamentales que deben abordarse.

- 0-2: Empático pero firme - el trabajo está incompleto y necesita una revisión sustancial.

En tu retroalimentación:

- Reconoce lo que la visualización sí revela sobre sus hábitos.

- Señala lo que está ausente o poco desarrollado (patrones, contextos o profundidad analítica).

- Si el grado de finalización de la cuadrícula es bajo (<50%), abórdalo directamente como un factor que limita el reconocimiento de patrones.

- No dejes de apuntar los fallos técnicos de la visualización, como colores no suficientemente distintos entre sí, símbolos poco claros o un número limitado o poco desarrollado de categorías de color o símbolos.

- Si las anotaciones son puramente descriptivas, anímalos a hacerse preguntas de “por qué”.

- Plantea 1-2 preguntas reflexivas específicas y adaptadas a sus datos.

Ejemplos de tonos:

Para un alto grado de finalización, bajo análisis (7/10): “Has documentado tres meses a fondo, ¡un compromiso impresionante! Tu cámara claramente gravita hacia los viajes y el ocio. Pero aquí está la pregunta más profunda: ¿Qué es invisible en este archivo? ¿El 80% de la vida entre viajes? Esta documentación selectiva sugiere que tu cámara es un ‘resumen de los mejores momentos’ (highlight reel). ¿Qué revelaría la fotografía diaria sobre tus rutinas reales en comparación con tu ‘yo’ aspiracional?”

Para un bajo grado de finalización (3/10): “El vacío de esta cuadrícula es en sí mismo un dato. ¿Qué te impidió llenarla? ¿Falta de tiempo? ¿Incomodidad con la autoexaminación? ¿O quizás simplemente no se tomaron muchas fotos en este período? Vale la pena interrogar esa falta de documentación. ¿Por qué tu cámara permanece en silencio durante semanas? ¿Qué momentos no ‘cuentan’ como dignos de ser fotografiados?”

Como podéis ver el prompt está dividido en varias secciones. Primero, empieza con elementos básicos como la definición del rol, contexto y tarea. Hemos añadido algunas partes que resulta fundamentales para aumentar la evaluación:

criterios de evaluación: una rúbrica clara y detallada que permita a la IA evaluar cada uno de los aspectos del ejercicio. Como veréis, es más detallada que la ofrecida a los estudiantes para orientar mejor a los modelos en cómo evaluar.

reglas de compromiso (rules of engagement): un conjunto de principios que guían el enfoque crítico y riguroso de la evaluación. Esto es especialmente importante para evitar que la IA sea demasiado indulgente o ambigua en su evaluación.

feedback: una sección dedicada a la retroalimentación constructiva y adaptada al nivel de desempeño del estudiante. Esto ayuda a la IA a proporcionar comentarios útiles y motivadores y que no sean demasiado extensos.

Ejemplos

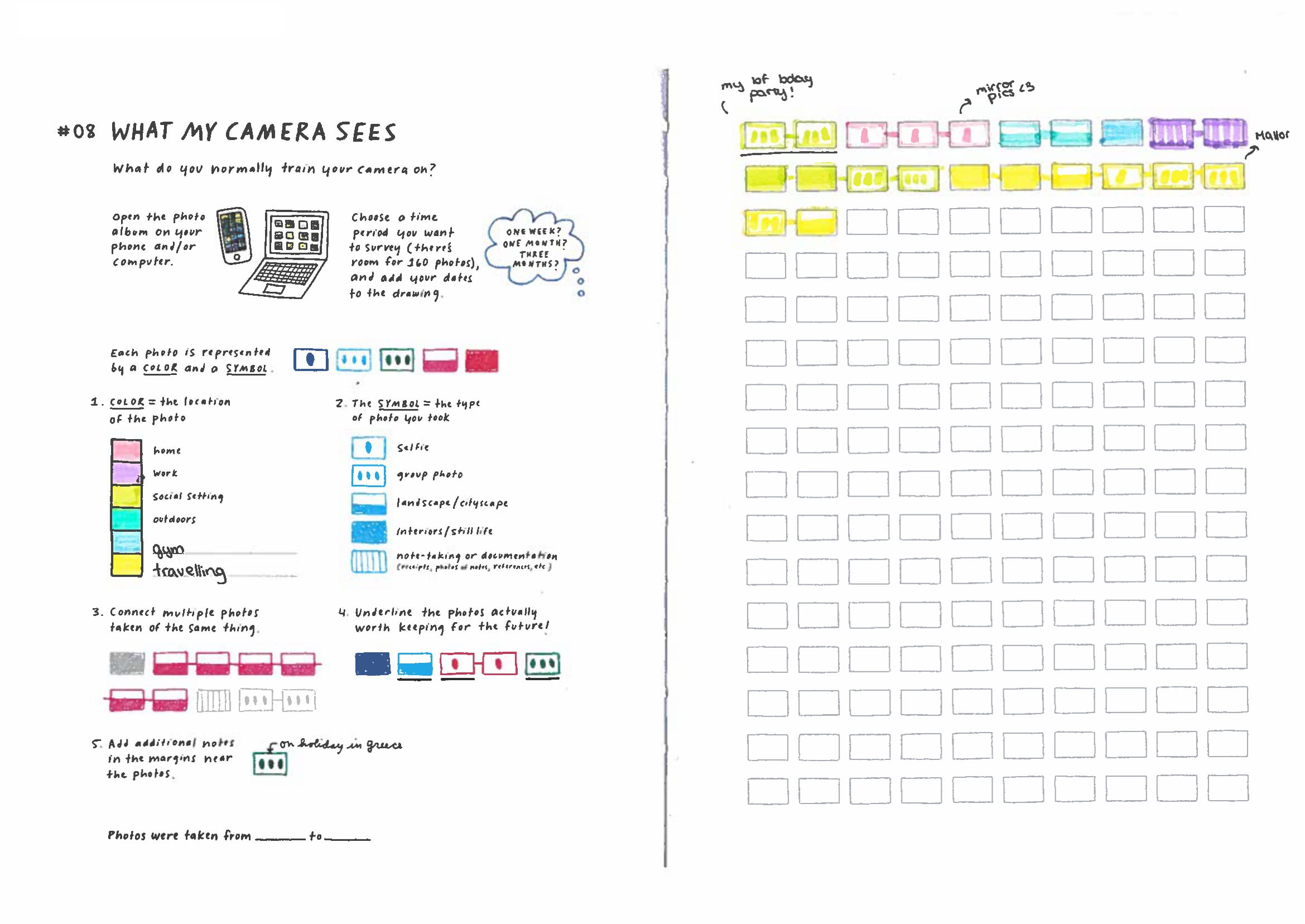

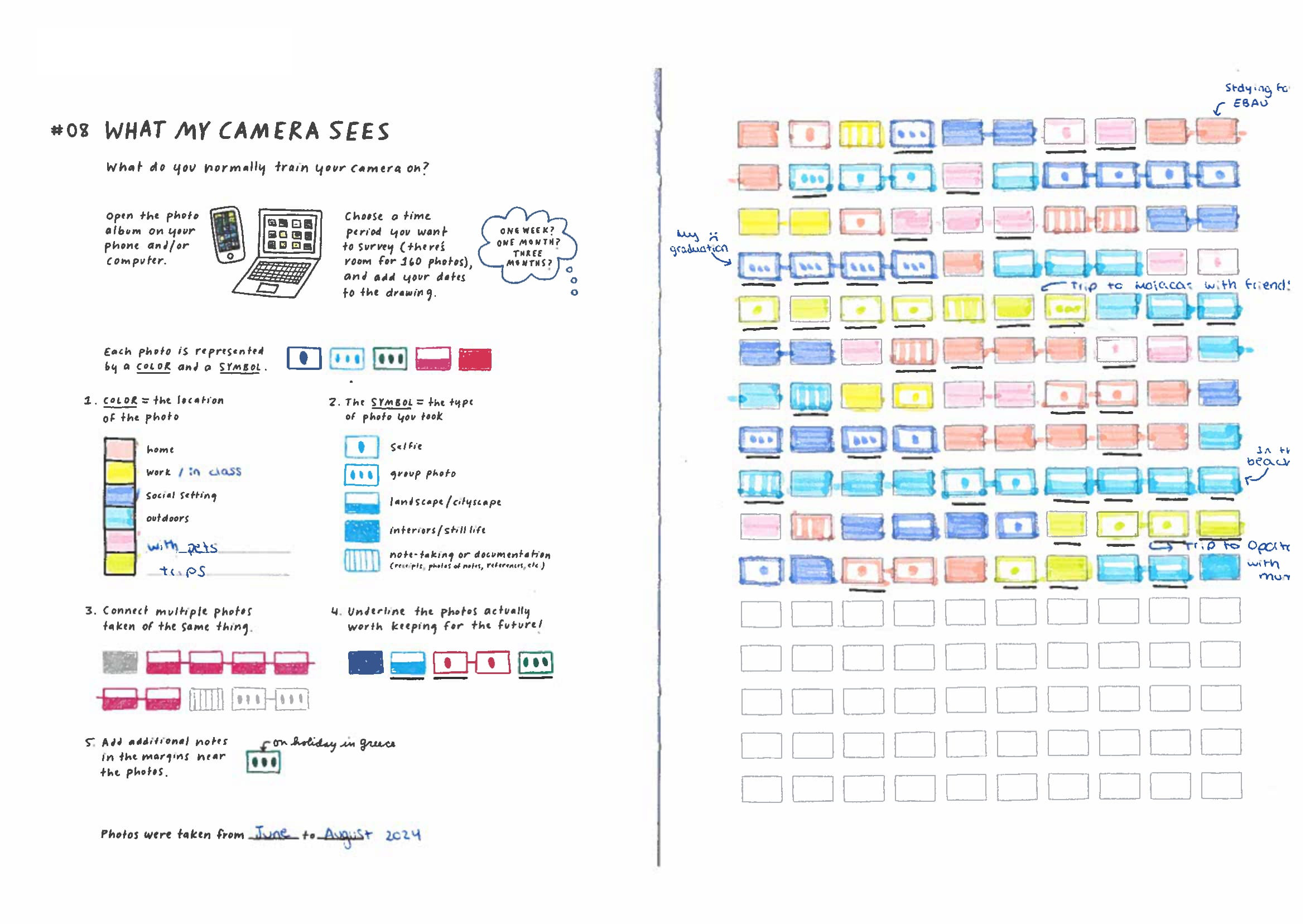

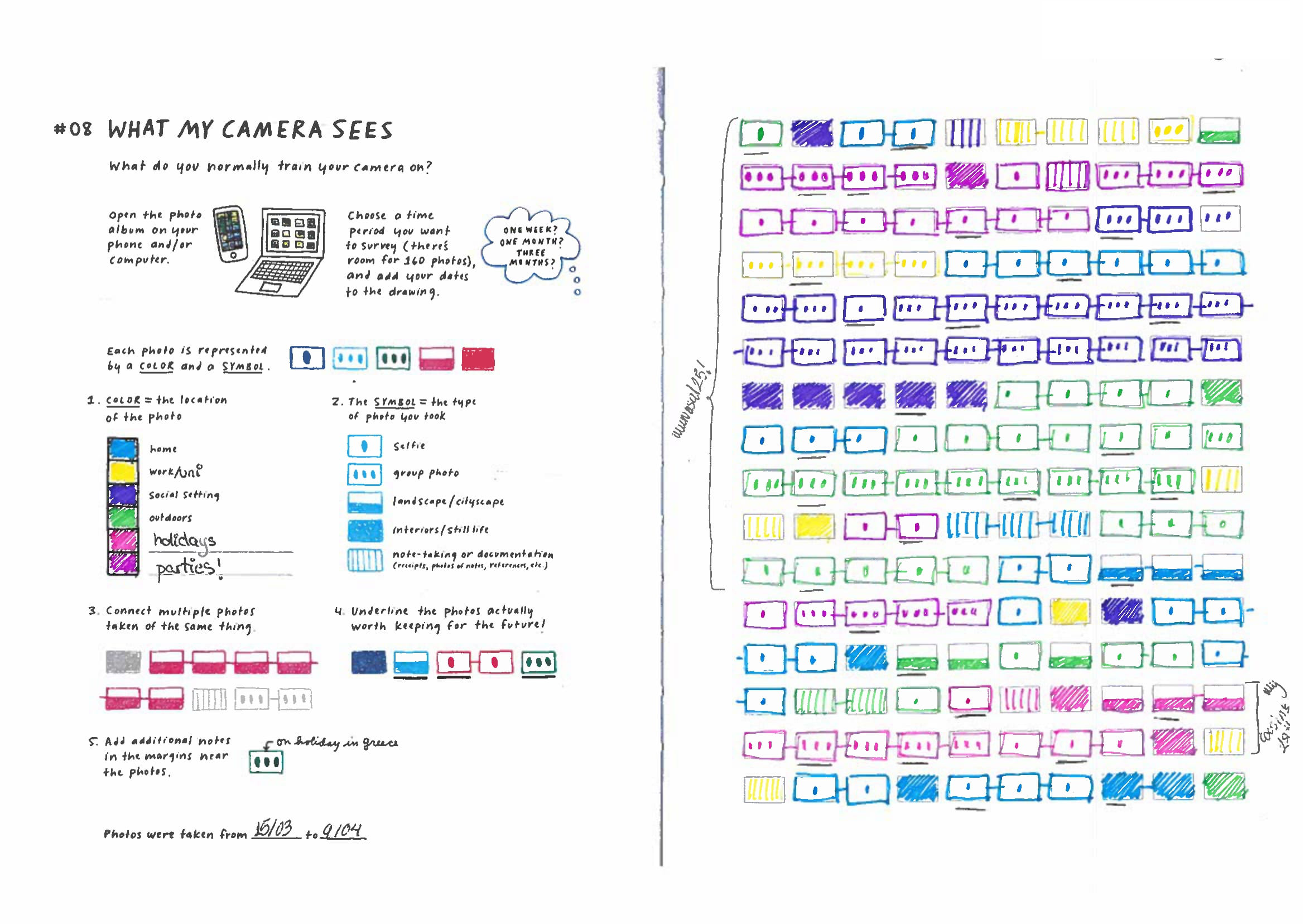

Abajo tenemos tres ejemplos de ejercicios resueltos por estudiantes debidamente anonimizados. Cada uno revela un desarrollo distinto y un nivel de calidad diferente. La IA debe evaluar cada uno de ellos siguiendo el prompt anterior.

Copiemos y peguemos el prompt y cada uno de ellos en el Google AI Studio para ver cómo el modelo lleva a cabo la evaluación.

Revisión

¿Qué os parece? ¿Los resultados son satisfactorios? ¿La evaluación es justa y adecuada? ¿El feedback es útil y motivador? En casi absoluta totalidad de los casos, hay que llevar a cabo una revisión extensiva de los resultados del modelo para calibrarlos a lo que se espera. Como hemos visto la semana pasada, podemos pedir a los modelos que generen versiones con diferentes calificaciones o niveles de desarrollo para testar el prompt y poder ajustar los resultados. No obstante, al preparar la actividad resultaría interesante también preparar algunas soluciones manuales o humanas con los niveles deseados. De ese modo, tendremos un control total sobre cómo el modelo va a evaluar la práctica. Otra alternativa, más económica, es adoptar un acercamiento híbrido: primero, pedir que el modelo genere las respuestas y, luego, editarlas para que correspondan a lo que deseamos para ajustar nuestro prompt.

Por lo tanto, las estrategias de generación de material serían:

Generación manual: crear las soluciones y respuestas de manera manual, asegurándonos de que cumplen con los niveles de calidad y desarrollo deseados.

Generación automática: utilizar la IA para generar las soluciones y respuestas, ajustando el prompt y los parámetros del modelo para obtener los resultados deseados.

Generación híbrida: combinar ambos enfoques, generando primero las respuestas con la IA y luego editándolas manualmente para ajustarlas a los niveles deseados.

Una vez producidas las soluciones de referencia y obtenidas las respuestas del (de los) modelo(s), se puede proceder a comparar y analizar los resultados. Esto nos permitirá identificar las fortalezas y debilidades del prompt y del modelo, así como ajustar y mejorar la evaluación para futuras iteraciones.

Una guía práctica consiste en:

precisión: Evaluar la efectividad en identificar los puntos fuertes y débiles de cada respuesta.

consistencia: Comprobar si el modelo mantiene un enfoque coherente en la evaluación a lo largo de diferentes respuestas y niveles de calidad.

ajuste a la rúbridca: Verificar si el modelo sigue adecuadamente los criterios de evaluación establecidos en la rúbrica y confiere una calificación adecuada según los puntos establecidos.

calidad del feedback: Analizar si los comentarios proporcionados son útiles, motivadores y adaptados al nivel de desempeño del estudiante. Aquí cabe señalar que feedback detallado ni siempre es el más productivo.

Podemos revisar manualmente el prompt o pedir a un modelo que nos ayude a identificar posibles mejoras o ajustes necesarios. Esto puede incluir la clarificación de instrucciones, la adición de ejemplos o la modificación de criterios de evaluación para mejorar la precisión y la utilidad de la evaluación. No obstante, hay que tener cuidado con pedir al modelo que genere un prompt. Mi experiencia es que los modelos suelen generar revisiones muy complejas y poco efectivas de los prompts iniciales. Cuanto más directamente vinculadas las instrucciones a los objetivos y la rúbrica, mejor.

Feedback

El tema del feedback consiste en un aspecto clave y problemático de la evaluación con IA. Todavía partimos de un punto en el que los estudiantes están acostumbrados a recibir una retroalimentación escasa para las prácticas realizadas. No obstante, con las posibilidades que abre la IA para mejorar el feedback, pronto veremos más y más estudiantes familiarizados con más información sobre su desempeño. Ya lo tienen incorporados en su rutina. Cuentan pasos, miden calorías, puntos, créditos. La ludificación de la vida y los smart gadgets ya han popularizado la cultura de la evaluación.

¿Cómo podemos aprovechar la IA para proporcionar un feedback más efectivo y útil a los estudiantes? En primer lugar, se trata de una herramienta de comunicación entre el profesor y los estudiantes sobre su desempeño en un proceso de evaluación o desarrollo en la asignatura. Por lo tanto, debe informar de forma clara los puntos fuertes y aspectos a desarrollar de cara a una actividad o evaluación. En ese sentido, debe ser claro, transparente y fácil de ser entendido por los estudiantes.

Además, los comentarios no deben dejar lugar a dudas o ambigüedades. Deben ser específicos y concretos, evitando generalizaciones o vaguedades que puedan confundir a los estudiantes. De ese modo, los profesores evitan conversaciones o solicitudes para subir nota, que son desgastantes y poco constructivas para la relación profesor-estudiante.

Por esa razón, cuando diseñamos el prompt, debemos considerar:

Claridad: El prompt debe especificar claramente que el feedback debe ser comprensible y directo, evitando tecnicismos o lenguaje excesivamente académico.

Especificidad: El prompt debe indicar que el feedback debe ser concreto y detallado, proporcionando ejemplos específicos de lo que se hizo bien y lo que se puede mejorar.

Tono adecuado: El prompt debe guiar al modelo para que utilice un tono apropiado según el nivel de desempeño del estudiante, adaptando el lenguaje y el enfoque para motivar y apoyar al estudiante en su aprendizaje.

Longitud adecuada: El prompt debe establecer límites claros sobre la extensión del feedback, asegurando que sea lo suficientemente detallado para ser útil, pero sin ser excesivamente largo o abrumador.

Como vemos en el prompt arriba, he incluido diversas especificaciones:

Claridad: - de apoyo pero honesto.

Especificidad: - señala lo que está ausente o poco desarrollado.

Tono adecuado: - calibración del tono por rango de puntuación, con ejemplos.

Longitud adecuada: - 100-150 palabras.

De ese modo, garantizo que el feedback generado por la IA sea un primer borrador útil para trabajar sobre él.

Aquí viene lo importante:

Los resultados de la IA son un insumo para que el profesor pueda elaborar un feedback final y adaptado a cada estudiante. La identificación de fallos y puntos fuertes sirve de checklist para agilizar la evaluación (no su automación). El feedback generado para ser destinado al estudiante, por su parte, funciona como un borrador (como de un correo electrónico) que tenemos que pulir para ajustar el contenido y el tono según nuestra evaluación personal. Esta también es una buena razón para mantener los comentarios cortos. Cuanto más directos, sintéticos y objetivos sean los comentarios, más fácil será revisarlos y añadir nuestras propias observaciones.

De ese modo, evitamos cruzar la línea roja de la automatización completa de la evaluación, que todavía no es posible ni deseable en la mayoría de los contextos educativos. La IA nos ayuda a ser más eficientes y efectivos en nuestra labor como educadores, pero la responsabilidad última de la evaluación y el feedback sigue siendo nuestra.

Acompañamiento

Además de evaluar, la IA puede resultar muy muy útil a la hora de identificar estudiantes con perfiles de riesgo de fracaso. Sería estupendo poder identificar dichos casos de forma rápida y poder intervenir con una o más charlas o tutorías cara a cara para identificar las dificultades y desarrollar estrategias comunes para lidiar con los obstáculos.

En la tabla abajo, podemos ver un grupo de estudiantes ficticios con sus notas en los primeros 5 ejercicios de la asignatura. Como podemos ver, hay varios estudiantes con una nota media hasta ahora baja. No obstante, también hay otros estudiantes con notas medias aceptables, pero con una tendencia descendente en sus calificaciones. Estos estudiantes también podrían beneficiarse de una intervención temprana para evitar que su rendimiento empeore.

Es ahí que la IA puede ser de una ayuda inestimable. Podemos diseñar un prompt que le permita analizar las notas de los estudiantes y clasificarlos en diferentes categorías de riesgo según sus promedios y tendencias. De ese modo, podemos generar un informe que nos ayude a identificar a los estudiantes que necesitan atención especial.

La mayoría de nosotros lleva el registro de las notas en hojas de cálculo o sistemas de gestión del aprendizaje (LMS). Por lo tanto, podemos exportar los datos en formato CSV y proporcionárselos a la IA para su análisis.

El prompt abajo está diseñado para el propósito de identificar a los estudiantes con problemas y clasificarlos según el nivel y el tipo de riesgo:

# Rol

Actúa como un analista de datos experto en el ámbito educativo. Te voy a proporcionar un archivo con las notas de mis estudiantes en los primeros 5 ejercicios del curso.

# tarea

Tu tarea es identificar proactivamente a los estudiantes con perfiles de riesgo para permitir una intervención temprana.

Define los perfiles de riesgo usando los siguientes criterios:

- Riesgo Alto (Alerta Roja): Estudiantes con una media inferior a 5.0 o cuya tendencia sea claramente descendente.

- Riesgo Moderado (Alerta Amarilla): Estudiantes con una media aprobatoria (entre 5.0 y 6.5) pero que muestren una tendencia descendente constante.

- Riesgo por Inconsistencia (Alerta Azul): Estudiantes con notas muy variables (diferencias de más de 4 puntos entre su mejor y peor nota).

Quiero que me devuelvas un informe estructurado en estas tres categorías de riesgo. Dentro de cada categoría, lista a los estudiantes y, para cada uno, incluye:

- Nombre y Apellido.

- Promedio actual.

- La razón específica de la alerta (ej: “Tendencia descendente”, “Promedio bajo”, “Alta volatilidad en notas”).

# Datos

En el CSV abajo puedes encontrar las notas de los estudiantes:

[CSV CON NOTAS]

He creado un archivo csv con las notas, Notas.csv, que permitirá que testemos el prompt con los modelos de IA.

Como vemos, el modelo ha identificado a los estudiantes con perfiles de riesgo y los ha clasificado en las categorías correspondientes. Además, ha proporcionado detalles específicos para cada estudiante, lo que facilita la planificación de intervenciones personalizadas.

Con este listado, podemos planificar tutorías o sesiones de apoyo específicas para cada estudiante, abordando sus necesidades particulares y ayudándoles a superar sus dificultades. De ese modo, podemos al menos intentar mejorar el rendimiento académico.